Endereço

Rua Bazilio da Silva, 209 - Apto 131-B - CEP: 05545-010 - São Paulo -SP

CNPJ: 32.412.810/0001-41

Endereço

Rua Bazilio da Silva, 209 - Apto 131-B - CEP: 05545-010 - São Paulo -SP

CNPJ: 32.412.810/0001-41

Se você colocar o ouvido no chão úmido das terras agrícolas de Indiana, nos Estados Unidos, talvez não escute o crescimento do milho ou o canto dos pássaros. O que se ouve hoje é um zumbido grave, profundo, quase uma vibração tectônica que sobe pelas solas dos sapatos. É o som da Mãe Terra sendo cirurgicamente transformada em uma placa-mãe colossal.

Há uma mudança sísmica acontecendo agora mesmo, debaixo dos nossos narizes, algo tão monumental que está redesenhando a indústria de energia, a geopolítica e o bolso de cada empresa de tecnologia do planeta. Durante a última década, a regra do jogo era entediante de tão simples: se você queria brincar de Inteligência Artificial, você precisava beijar o anel da NVIDIA. Você entrava na fila, pagava o preço de um apartamento de luxo por um punhado de placas H100 e agradecia se elas chegassem antes do Natal do ano seguinte.

Mas o vento mudou. O “negócio da China” da NVIDIA, que parecia uma fortaleza inexpugnável, começou a mostrar fissuras. As gigantes do Vale do Silício — Amazon, Google, Microsoft — cansaram de ser reféns. Cansaram de ver suas margens de lucro serem devoradas pelo “imposto verde” de Jensen Huang. A revolta do silício começou, e o campo de batalha não é um laboratório futurista de vidro, mas galpões poeirentos no meio do nada.

Prepare-se. O que vou te contar nas próximas linhas vai desmontar tudo o que você achava que sabia sobre data centers, nuvem e o futuro da computação. Estamos assistindo ao divórcio mais caro da história.

Vamos dar a César o que é de César: a NVIDIA fez um trabalho espetacular. Eles construíram o motor da revolução da IA. Mas existe um segredo sujo, uma espécie de sussurro nos corredores das Big Techs, que ninguém gostava de admitir em voz alta. As GPUs, por mais poderosas que sejam, são ferramentas generalistas. Elas são como canivetes suíços glorificados. Elas renderizam o gráfico ultra-realista do seu jogo favorito, mineram aquela criptomoeda duvidosa e, sim, treinam redes neurais.

O problema de um canivete suíço é que, quando você precisa fazer uma cirurgia cerebral delicada, ele é pesado, desajeitado e cheio de lâminas que você não vai usar. E custa caro.

A escassez das placas Blackwell e Hopper da NVIDIA não é apenas uma questão de “fazer mais chips”. O buraco é muito mais embaixo. O verdadeiro vilão, o gargalo que está tirando o sono dos executivos, é uma tecnologia minúscula de empacotamento chamada CoWoS (Chip-on-Wafer-on-Substrate). A TSMC, a fábrica que faz os chips para todo mundo, não consegue colar a memória no processador rápido o suficiente.

O resultado? Uma fila de espera quilométrica e preços que fariam um xeique do petróleo hesitar. Um único rack de servidores pode custar 3 milhões de dólares. Agora, multiplique isso por milhares de racks para encher um data center. É uma conta que não fecha. É insustentável. E é nesse cenário de desespero financeiro e logístico que a Amazon decidiu chutar o balde e fazer algo que muitos chamariam de suicídio comercial.

O Plano da Amazon, Google e Microsoft para Quebrar a Dependência da NVIDIA.

Imagine uma cidadezinha chamada New Carlisle. População: 1.900 habitantes. Um lugar onde a maior emoção da semana provavelmente era o bingo da igreja. De repente, a paisagem bucólica foi invadida por guindastes, caminhões e engenheiros. Não para plantar soja, mas para plantar o futuro.

Nasceu ali o Projeto Rainier. E o detalhe mais chocante, aquele que faz qualquer especialista em hardware cair da cadeira? Dentro daqueles galpões gigantescos, que consomem energia suficiente para iluminar uma capital, não existe uma única GPU da NVIDIA.

Zero. Niente. Nada.

Isso é audacioso. É a primeira vez na história moderna da IA que vemos um supercluster dessa magnitude — estamos falando de quase 1 milhão de processadores de IA sob o mesmo teto — construído inteiramente fora do ecossistema da NVIDIA. É como se alguém decidisse montar uma Fórmula 1 sem usar peças de carro, reinventando a roda do zero.

A Amazon olhou nos olhos do monopólio e disse: “Não, obrigado. Nós vamos fazer do nosso jeito”. E o jeito deles envolveu desenhar seus próprios chips, forjados no fogo da necessidade e da economia.

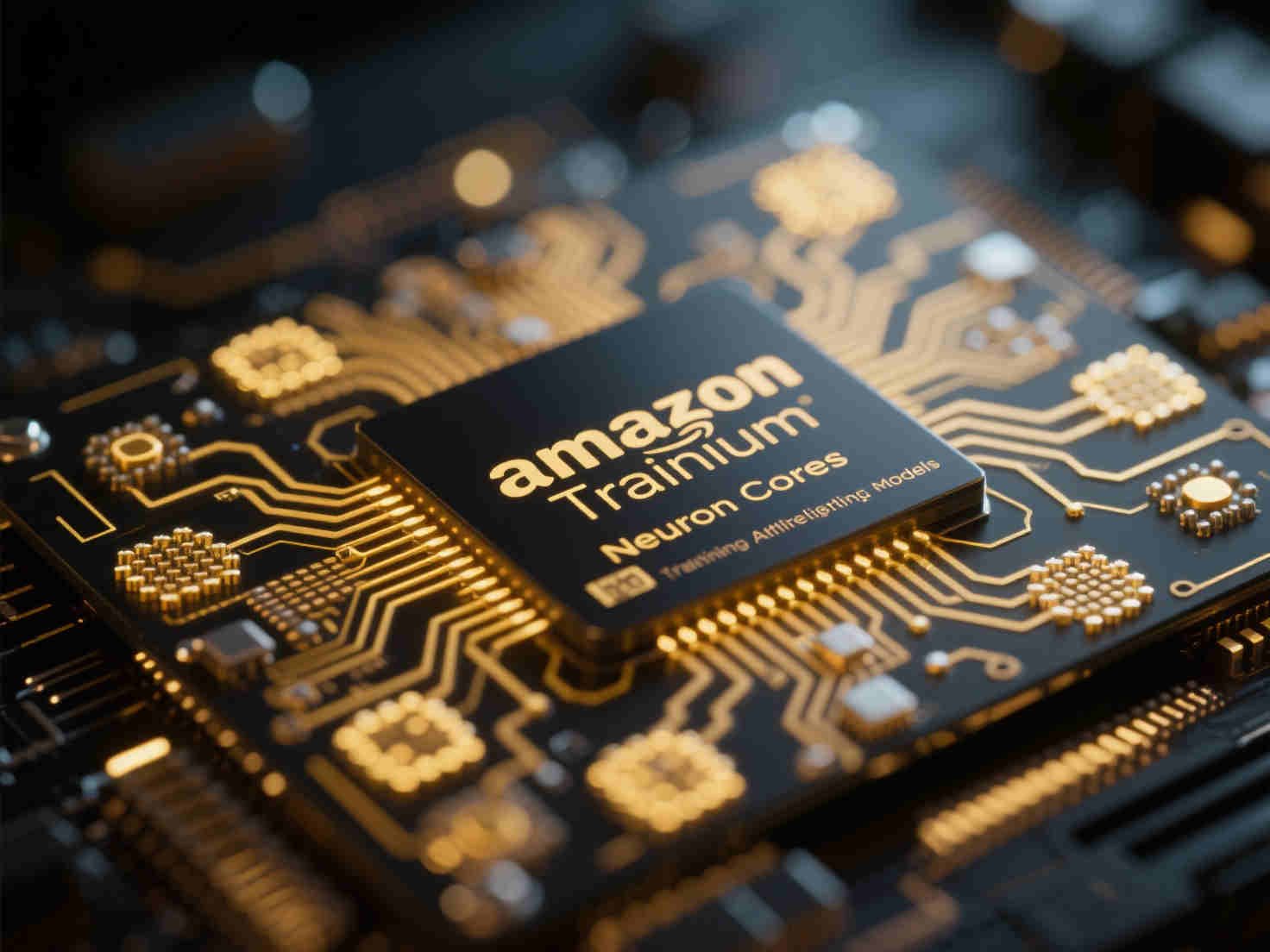

Aqui entra o nosso herói improvável (ou vilão, dependendo de quantas ações da NVIDIA você tem): o chip Trainium. Diferente das GPUs, que tentam abraçar o mundo, o Trainium é um ASIC (Application Specific Integrated Circuit). Trocando em miúdos: é um especialista. Ele nasceu, cresceu e vive apenas para uma única e monótona tarefa: treinar modelos de linguagem gigantescos.

Se você abrisse um Trainium 2 com um microscópio, não veria os núcleos CUDA que os gamers idolatram. Você veria “Neuron Cores”, arquitetura desenhada especificamente para a matemática pesada das redes neurais. A Amazon pegou o algoritmo que faz a IA “pensar” e, literalmente, gravou ele no silício.

O resultado dessa engenharia focada?

Para a AWS, isso não é apenas uma “vantagem competitiva”. Isso é a diferença entre queimar dinheiro numa fogueira sem fim ou dominar o mercado pelos próximos dez anos. Eles estão jogando um xadrez 4D, onde a eficiência por watt vale mais do que a força bruta dos benchmarks.

Você acha que desenhar o chip é a parte difícil? Ledo engano. O verdadeiro “Boss Final” desse jogo é a rede elétrica.

O Projeto Rainier, quando estiver operando a todo vapor, vai puxar cerca de 2 Gigawatts de potência. Para colocar isso em perspectiva, é como plugar dois DeLorean do “De Volta para o Futuro” no momento do raio, mas manter isso ligado 24 horas por dia. É a energia de uma nação pequena concentrada em alguns hectares de Indiana. A rede elétrica local olhou para essa demanda e tremeu.

As GPUs e aceleradores de IA são “divas” temperamentais. Elas não bebem eletricidade de canudinho, de forma constante. Elas dão goladas violentas. Num milissegundo a demanda é baixa; no outro, BOOM, ela explode. Se a rede elétrica não tiver “cintura” para lidar com esses solavancos, o sistema colapsa. Um apagão ali não é só ficar no escuro; é perder milhões de dólares em processamento de modelos que estavam sendo treinados há semanas.

A solução da Amazon foi transformar o data center numa usina de estabilização. Eles instalaram bancos de baterias colossais, não para durar horas, mas para “alisar” a energia. As baterias engolem o excesso e preenchem as falhas. É um amortecedor de luxo para elétrons rebeldes.

As Big Techs deixaram de ser apenas empresas de software. Elas viraram magnatas da energia. A Amazon comprou um data center colado numa usina nuclear na Pensilvânia — literalmente ligado direto no reator — para garantir que a luz nunca apague. A briga agora é por quem consegue segurar o cabo de alta tensão sem se queimar.

Toda essa eletricidade vira uma coisa inevitável: calor. Um oceano de calor. Estamos falando de 2 Gigawatts de energia térmica presos entre quatro paredes. É o suficiente para transformar os servidores em poças de metal derretido em questão de minutos.

Tradicionalmente, a solução da engenharia é jogar água. Milhões e milhões de galões de água para resfriar as máquinas. Mas isso cria um problema ético: secar os aquíferos locais. Imagine a manchete: “Amazon seca cidade para que você possa pedir uma receita de bolo ao ChatGPT”. O pesadelo de Relações Públicas seria devastador.

Então, no Projeto Rainier, eles tomaram uma decisão curiosa, quase retrógrada. Eles apostaram no ar.

Paredes imensas, verdadeiros paredões de ventoinhas, sopram incessantemente através dos corredores. De outubro a março, o frio congelante de Indiana faz o trabalho pesado, usando zero água. Nos meses quentes, a água entra em cena apenas por algumas horas críticas.

Mas, como na vida, não existe almoço grátis. O ar é um péssimo condutor de calor comparado à água (cerca de 30% menos eficiente). Para compensar, as ventoinhas precisam girar como turbinas de avião, criando um barulho ensurdecedor e consumindo ainda mais daquela preciosa energia elétrica. É o cobertor curto da tecnologia: cobre a cabeça (economiza água), descobre os pés (gasta energia).

Falando em manter as coisas frias… Se o seu PC está parecendo uma turbina de avião tentando rodar aquele jogo pesado ou renderizar um vídeo, talvez seja hora de dar um upgrade na refrigeração antes que ele derreta.

❄️ Confira este Cooler de Alta Performance (Fan RGB) na Shopee e salve seu setup: https://s.shopee.com.br/8KipGMIQg2

❄️ Confira este Drone DJI Mini 4K: https://s.shopee.com.br/7KqI4smTi5

Nessa cruzada obsessiva para cortar custos e se livrar de dependências externas, a Amazon tomou outra decisão técnica que fez os engenheiros de rede coçarem a cabeça em descrença: eles apostaram no cobre.

Em data centers de IA de ponta, a etiqueta dita o uso de fibra óptica. A luz viaja rápido, não esquenta e alcança longas distâncias sem perder o fôlego. É elegante, é futurista… e é caro pra burro. Os transceptores ópticos são peças de joalheria tecnológica.

A Amazon olhou para a fibra e disse: “Vamos usar cobre”. Sim, o bom e velho fio de cobre, aquele metal laranja e pesado. É barato, robusto e qualquer técnico sabe instalar. O problema? A física implacável. Em velocidades extremas de transmissão de dados (estamos falando de Terabits), o sinal elétrico no cobre se degrada depois de alguns palmos.

Para fazer essa “gambiarra de luxo” funcionar, os engenheiros tiveram que fazer malabarismos no design físico dos racks, aproximando os chips de tal forma que os cabos fossem curtos o suficiente para a física não reclamar. É uma solução “feia” para os puristas da óptica, mas linda para os contadores. Funciona, é barato e escala rápido. Às vezes, a inovação não é um laser, mas saber dobrar um fio velho de um jeito novo.

Aqui a trama ganha ares de conspiração corporativa. Por que a Amazon está tão confiante no Trainium, a ponto de apostar o futuro da empresa nele? Porque eles têm um cliente âncora que não tem escolha.

A Amazon investiu bilhões na Anthropic (a mãe do Claude, o grande rival do ChatGPT). Mas esse dinheiro não foi uma doação caridosa. Parte do acordo tácito é: “Nós te damos o dinheiro, e você gasta esse dinheiro alugando nossos servidores com nossos chips Trainium”.

É um ciclo perfeito, o “Ouroboros” financeiro. O dinheiro sai do bolso da Amazon, vai para a conta da Anthropic, e volta para o cofre da Amazon como receita de nuvem AWS, enquanto valida a tecnologia do chip Trainium para o resto do mundo. A Anthropic ganha poder de computação barato; a Amazon ganha um estudo de caso massivo para provar que a vida existe fora da NVIDIA.

E não se engane, não é só a Amazon. O Google faz o mesmo com seus TPUs e o DeepMind. A Microsoft faz o mesmo com a OpenAI e seus novos chips Maia. É o “loop de capital” que mantém a roda girando e acelera o desenvolvimento de chips proprietários, deixando a NVIDIA, pouco a pouco, fora da festa das Big Techs.

Seria uma injustiça histórica falar dessa revolta sem tirar o chapéu para o veterano de guerra: o Google. Enquanto o resto do mundo corria atrás de GPUs como baratas tontas anos atrás, o Google já estava no seu laboratório secreto desenvolvendo a TPU (Tensor Processing Unit).

A TPU é, talvez, a expressão mais pura do que um chip de IA deve ser. O Gemini, a IA que responde suas perguntas no Google, roda nessas belezas. E agora, com a NVIDIA cobrando o preço de órgãos vitais por seus chips, todo mundo quer um pedaço da TPU. A Apple usa, a Midjourney usa. O Google provou que é possível viver — e prosperar — fora da sombra da NVIDIA. Eles mostraram que, quando você controla o chip, o data center, a refrigeração e o software, você atinge um nirvana de eficiência inalcançável para quem apenas monta peças de LEGO compradas na prateleira.

Agora, você deve estar pensando: “Ok, a Amazon e o Google estão construindo suas próprias usinas e chips. Mas eu não sou a Amazon. Eu não tenho 2 Gigawatts de energia nem uma equipe para desenhar silício. O que eu faço?”

Aqui está a ironia do destino. Enquanto as Big Techs fogem para o silício customizado para treinar seus modelos massivos na nuvem pública, o mercado corporativo — bancos, governos, indústrias — precisa de performance garantida, compatibilidade e controle dentro de casa ou em colocation. Vocês não estão treinando o próximo GPT-5; vocês estão rodando inferência, análise de dados sensíveis e aplicações críticas que precisam da robustez que, paradoxalmente, a NVIDIA ainda entrega melhor que ninguém no ecossistema privado.

A revolução para a sua empresa não é construir um chip, é construir a arquitetura certa. É aqui que a mágica do design de rede entra.

As Big Techs provaram que a arquitetura tradicional de data center está morta para a IA. O modelo antigo de três camadas não aguenta o tranco. O segredo está na arquitetura Spine/Leaf. É esse design que permite a baixa latência e a largura de banda explosiva que a IA exige.

Você não precisa ir para Indiana. Você precisa de inteligência de infraestrutura aqui, no Brasil.

É vital entender que implementar um cluster de IA ou modernizar seu Data Center não é plugar cabos aleatoriamente. Exige uma engenharia de tráfego de dados precisa. Grandes instituições já perceberam isso. A Serasa, lidando com dados de milhões de brasileiros, a Infraero, controlando a logística aérea, e a Prefeitura de Jundiaí, digitalizando serviços públicos — todas essas entidades operam sobre infraestruturas robustas que não aceitam falhas.

E onde essas infraestruturas moram? Nos hubs de conectividade mais críticos do país, como os Data Centers da Cirion Technologies em São Paulo e no Rio de Janeiro. Mas quem desenha e implementa essas artérias digitais?

É aqui que a Netadept Technology se destaca.

Nós não vendemos apenas “peças”. Nós somos especialistas em desenhar e implementar a arquitetura Spine/Leaf que sustenta operações críticas como as da Serasa, Infraero e Prefeitura de Jundiaí. Nós conhecemos cada centímetro dos data centers da Cirion Technologies no Rio e em SP.

Mas fomos além. Sabemos que sua empresa quer entrar na Era da IA, mas com controle e privacidade. Por isso, implementamos a solução Nexus Hyperfabric AI.

Imagine ter o seu próprio “POD de IA” dedicado, dentro do seu Data Center, equipado com os poderosos servidores Cisco UCS 885A e, sim, as GPUs NVIDIA escaláveis que você precisa para rodar seus modelos com compatibilidade total. Nós trazemos a robustez da NVIDIA, orquestrada pela inteligência da arquitetura Cisco Spine/Leaf, instalada e suportada por quem já fez isso para os gigantes do Brasil.

Não tente reinventar a roda sozinho. Tenha sua própria superestrutura de IA.

🚀 Fale com nossos especialistas em Data Center e IA: https://netadept-info.com/

O que estamos vendo em New Carlisle com o Projeto Rainier não é necessariamente o fim da NVIDIA, mas é o fim do seu monopólio absoluto na nuvem pública.

O futuro da IA será híbrido, bagunçado e fascinante. Teremos os “jardins murados” da Amazon e Google rodando em chips proprietários (Trainium e TPU) para tarefas massivas, enquanto o mundo corporativo — o seu mundo — rodará em arquiteturas privadas de alta performance, baseadas em NVIDIA e Cisco, mas desenhadas com a inteligência de topologias Spine/Leaf para maximizar cada watt e cada real investido.

As Big Techs decidiram que a infraestrutura — a terra, a energia, o chip e o cabo — é importante demais para ser terceirizada. E a sua empresa? Vai continuar tratando a infraestrutura de TI como uma commodity ou vai assumir o controle dos seus dados com a arquitetura correta?

A revolta do silício já começou. As cartas estão na mesa. O zumbido no campo está ficando mais alto. E quem não tiver a infraestrutura pronta para ouvir, vai ficar surdo no silêncio da obsolescência.

Veja nosso video completo no Youtube: https://youtu.be/I4WZ_LHW2xw/